- Теорема Шеннона-Хартли

-

Теорема Шеннона-Хартли

Теорема Шеннона-Хартли в теории информации — применение теоремы кодирования канала с шумом к архетипичному случаю непрерывного временного аналогового канала коммуникаций, искаженного гауссовским шумом. Теорема устанавливает шенноновскую ёмкость канала, верхнюю границу максимального количества безошибочных цифровых данных (то есть, информации), которое может быть передано по такой связи коммуникации с указанным полоса пропускания в присутствии шумового вмешательства, согласно предположению, что мощность сигнала ограничена, и Гауссовский шум характеризуется известной мощностью или мощностью спектральной плотности. Закон назван в честь Клода Шеннона и Ральфа Хартли.

Содержание

Утверждение теоремы

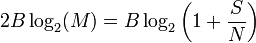

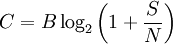

Рассматривая все возможные многоуровневые и многофазные методы шифрования, теорема Шеннона-Хартли утверждает, что ёмкость канала C, означающая теоретическую верхнюю границу скорости передачи данных, которые можно передать с данной средней мощностью сигнала S через аналоговый канал связи, подверженный аддитивному белому гауссовскому шуму мощности N равна:

где

- C — ёмкость канала в битах в секунду;

- B — полоса пропускания канала в герцах;

- S — полная мощность сигнала над полосой пропускания, измеренной в ваттах или вольтах в квадрате;

- N — полная шумовая мощность над полосой пропускания, измеренной в ваттах или вольтах в квадрате;

- S/N — отношение сигнала к шуму(SNR) сигнала к гауссовскому шуму, выраженное как отношение мощностей.

История развития

В течение конца 1920-ых Гарри Найквист и Ральф Хартли разработали фундаментальные идеи, связанные с передачей информации, с помощью телеграфа как система коммуникаций. В то время, это был прорыв, но науки как таковой не существовало. В 1940-ых, Клод Шеннон ввел понятие способности канала, которое базировалось на идеях Найквиста и Хартли, а затем сформулировал полную теорию передачи информации.

Критерий Найквиста

В символьном виде,

где fp - частота пульса (пульсов в секунду), и B — полоса пропускания (в герц).Формула Хартли

Теоремы Шеннона для канала с шумами

Теоремы Шеннона для канала с шумами (теоремы Шеннона для передачи по каналу с шумами) связывают пропускную способность канала передачи информации и существование кода, который возможно использовать для передачи информации по каналу с ошибкой, стремящейся к нулю (при увеличении длины блока).

Если скорость передачи сообщений меньше пропускной способности канала связи,

то существуют коды и методы декодирования такие, что средняя и максимальная вероятности ошибки декодирования стремятся к нулю, когда длина блока стремится к бесконечности,

Если же

то тогда, на основе которого можно добиться сколько угодной малой вероятности возникновения ошибки, не существует.

Теорема Шеннона-Хартли

В данной теореме определено, что достичь максимальной скорости (бит/сек) можно путем увеличения полосы пропускания и мощности сигнала и, в то же время, уменьшения шума.

Теорема Шеннона-Хартли ограничивает информационную скорость (бит/с) для заданной полосы пропускания и отношения сигнал/шум. Для увеличения скорости необходимо увеличить уровень полезного сигнала, по отношению к уровню шума.

Если бы существовала бесконечная полоса пропускания, бесшумовой аналоговый канал, то можно было бы передать неограниченное количество безошибочных данных по ней за единицу времени . Реальные каналы имеют ограниченные размеры и в них всегда присутствует шум.

Удивительно, но не только ограничения полосы пропускания влияют на количество передаваемой информации. Если мы комбинируем шум и ограничения полосы пропускания, мы действительно видим, что есть предел количества информации, которую можно было передать , даже используя многоуровневые методы кодирования . В канале, который рассматривает теорема Шеннона-Хартли, шум и сигнал дополняют друг друга. Таким образом, приемник воспринимает сигнал, который равен сумме сигналов, кодирующего нужную информацию и непрерывную случайную, которая представляет шум. Это дополнение создает неуверенность относительно ценности оригинального сигнала. Если приемник обладает информацией о вероятности ненужного сигнала, который создает шум,то можно восстановить информацию в оригинальном виде, рассматривая все возможные влияния шумового процесса. В случае теоремы Шеннона-Хартли шум, как таковой, произведен Гауссовским процессом с некоторыми отклонениями в канале передачи. Такой канал называют Совокупным Белым Гауссовским Шумовым каналом, так как Гауссовский шум является частью полезного сигнала;" белый" подразумевает равное количество шума во всех частотах в пределах полосы пропускания канала. Такой шум может возникнуть при воздействии случайных источников энергии а также быть связан с ошибками,возникшими при кодировании. Зная о вероятности возникновения Гауссовского шума, значительно упрощается определение полезного сигнала.

Значение теоремы

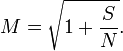

Сравнение способности Шеннона к законному Сравнению Хартли

способности канала к информационной норме из закона Хартли, мы можем найти эффективное число различимых уровней

квадратный корень эффективно преобразовывает отношение мощности в отношение напряжения, таким образом число уровней приблизительно пропорционально отношению среднеквадратической амплитуды сигнала к шумовому стандартному отклонению. Это подобие в форме между способностью Шаннона и законом Hartley's не должно интерпретироваться, чтобы означать, что М. уровней пульса можно буквально послать без любого беспорядка; больше уровней необходимо, чтобы учесть избыточное кодирование и устранение ошибки, но чистая скорость передачи данных, к которой можно приблизиться с кодированием, эквивалентна использованию того М. в законе Хартли.

Примечания

См. также

Wikimedia Foundation. 2010.

Теорема Шеннона — Хартли в теории информации применение теоремы кодирования канала с шумом к архетипичному случаю непрерывного временного аналогового канала коммуникаций, искажённого гауссовским шумом. Теорема устанавливает шенноновскую ёмкость канала,… … Википедия

Хартли, Ральф — Ральф Винтон Лайон Хартли англ. Ralph Vinton Lyon Hartley … Википедия

Теорема Котельникова — (в англоязычной литературе теорема Найквиста Шеннона или теорема отсчётов) гласит, что, если аналоговый сигнал имеет финитный (ограниченный по ширине) спектр, то он может быть восстановлен однозначно и без потерь по своим дискретным… … Википедия

Шеннона теорема — Теорема Котельникова (в англоязычной литературе теорема Найквиста) гласит, что, если аналоговый сигнал x(t) имеет ограниченный спектр, то он может быть восстановлен однозначно и без потерь по своим дискретным отсчётам, взятым с частотой более… … Википедия

Формула Хартли — определяет количество информации, содержащееся в сообщении длины n. Имеется алфавит А, из букв которого составляется сообщение: Количество возможных вариантов разных сообщений: где N возможное количество различных сообщений, шт; m … … Википедия

Алгоритм Шеннона — Фано — Алгоритм Шеннона Фано один из первых алгоритмов сжатия, который впервые сформулировали американские учёные Шеннон и Фано (англ. Fano). Данный метод сжатия имеет большое сходство с алгоритмом Хаффмана, который появился на несколько лет … Википедия

Кодирование Шеннона-Фано — Алгоритм Шеннона Фано один из первых алгоритмов сжатия, который впервые сформулировали американские учёные Шеннон и Фано. Данный метод сжатия имеет большое сходство с алгоритмом Хаффмана, который появился на несколько лет позже. Алгоритм… … Википедия

Код Шеннона-Фано — Алгоритм Шеннона Фано один из первых алгоритмов сжатия, который впервые сформулировали американские учёные Шеннон и Фано. Данный метод сжатия имеет большое сходство с алгоритмом Хаффмана, который появился на несколько лет позже. Алгоритм… … Википедия

Алгоритм Шеннона — Алгоритм Шеннона Фано один из первых алгоритмов сжатия, который впервые сформулировали американские учёные Шеннон и Фано (англ. Robert Fano). Данный метод сжатия имеет большое сходство с алгоритмом Хаффмана, который появился на… … Википедия

Шеннон, Клод — В Википедии есть статьи о других людях с такой фамилией, см. Шеннон. Клод Элвуд Шеннон Claude Elwood Shannon … Википедия